L’EDHEC Artificial Intelligence Centre a lancé son Bootcamp “Me, Myself and AI”

Les 6 et 7 janvier 2026, à Lille, l’EDHEC Artificial Intelligence Centre a organisé son premier bootcamp consacré à la réflexion sur l’usage de l’intelligence artificielle : « Me, myself and AI ». Destiné aux 750 étudiants en Pré-Master de l’école, cet événement leur a permis de saisir le potentiel des intelligences numériques, mais aussi d’acquérir les méthodes pour s’en servir de façon responsable.

Michelle Sisto, professeure associée, doyenne associée et directrice de l’EDHEC Artificial Intelligence Centre a organisé le lancement de ce premier bootcamp sur l’intelligence artificielle. Il s’est articulé autour de conférences, réflexions personnelles et travaux de groupe. Durant ce séminaire, 350 étudiants ont été accompagnés chaque jour par 14 facilitateurs : des professeurs et chercheurs transdisciplinaires de l’institution* et des experts en innovation pédagogique, comme Emmanuelle Houet, directrice du PiLab de l'EDHEC, Claudia Carrone, deputy manager EDHEC PiLab, ou encore Clément Lemainque et Ethan Pierse, tous deux consultants en IA.

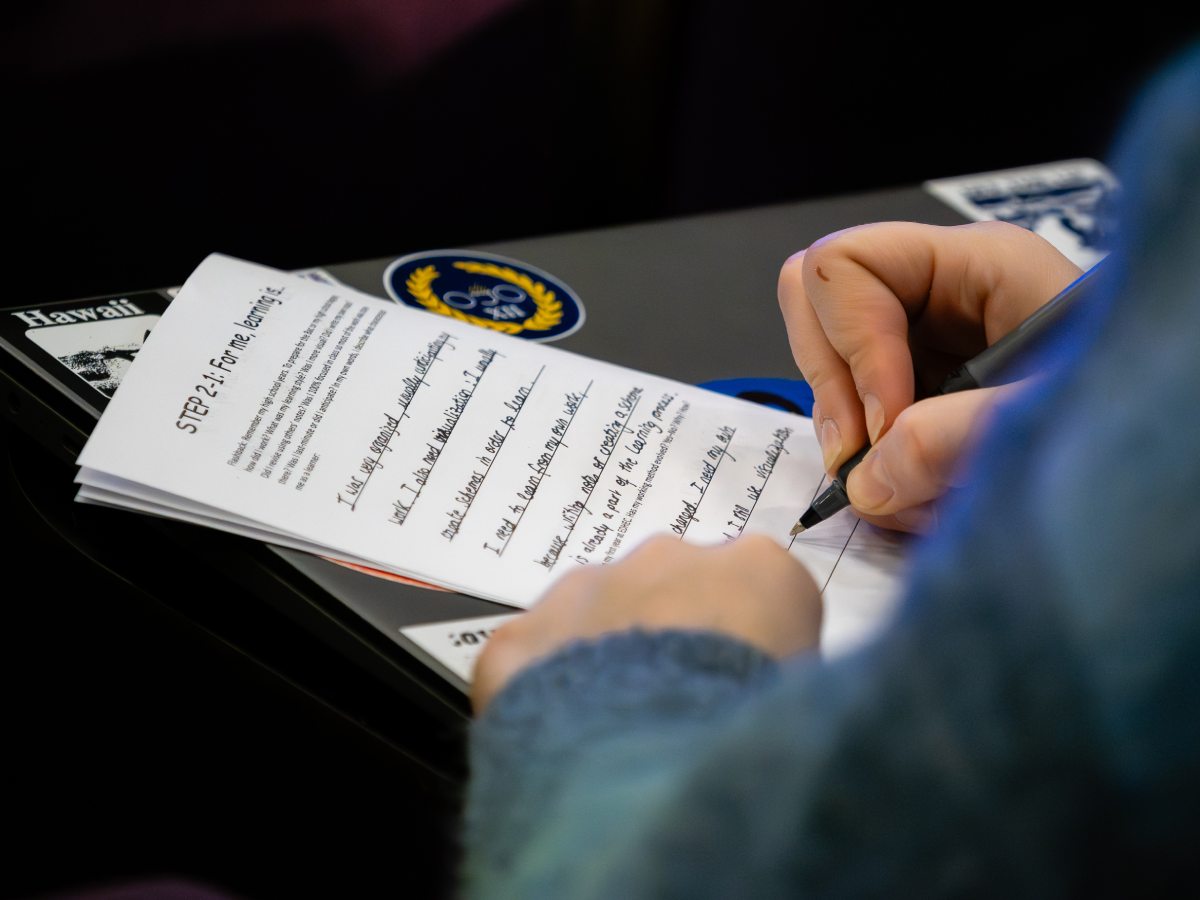

A l’occasion de ce premier bootcamp, un journal de bord a été remis aux étudiants. L’objectif ? Rassembler leurs réflexions sur l’IA : Mon rapport à cet outil a-t-il évolué avec le temps ? Comment peut-il m’aider ou nuire à mon apprentissage ? Quelles sont les forces et faiblesses des différents LLM (Large Language Model) que j’utilise ?

La journée se déclinait autour du cadre LEAD (Learning, Ethics, Accuracy, Development) du module « AI Literacy for All », développé par le Digital Education Council dont l'EDHEC Business School fait partie, et complété par les étudiants en amont du bootcamp.

Mettre l’IA au service de l’apprentissage

Lors de la première partie de la matinée, en amphithéâtre, les étudiants ont été invités à identifier leur style d’apprentissage — visuel, rédactionnel, musical, etc. En binômes, ils ont ensuite échangé à ce sujet et ont réfléchi à la manière dont l’IA pourrait les accompagner dans l’assimilation de connaissances. Ce travail d’introspection a été nourri par une présentation de Michelle Sisto, qui a exposé les résultats d’une étude sur l’usage de l’IA par les étudiants de l’EDHEC (fréquence, types d’utilisation, objectifs). Pour poursuivre ces réflexions, Emmanuelle Deglaire a pris la parole autour des différents modes d’apprentissage (linguistique, logique, interpersonnel, …) et la manière dont une mauvaise utilisation de l’IA peut affecter la cognition**.

Les étudiants se sont ensuite répartis en groupes pour réaliser deux exercices. Le premier consistait à réfléchir à une problématique autour du recrutement dans une association étudiante de l’EDHEC : comment développer une stratégie innovante pour engager davantage d’élèves ? Pour mener à bien l’exercice, les groupes ont eu recours à différents modes de recherche : identifier des idées innovantes par la seule discussion de groupe, interroger plusieurs IA à travers des prompts simples, puis formuler des prompts complexes à partir des idées dégagées par les deux méthodes précédentes. L’objectif de cette activité : apprendre aux étudiants à utiliser l’IA uniquement pour augmenter la richesse de leurs idées.

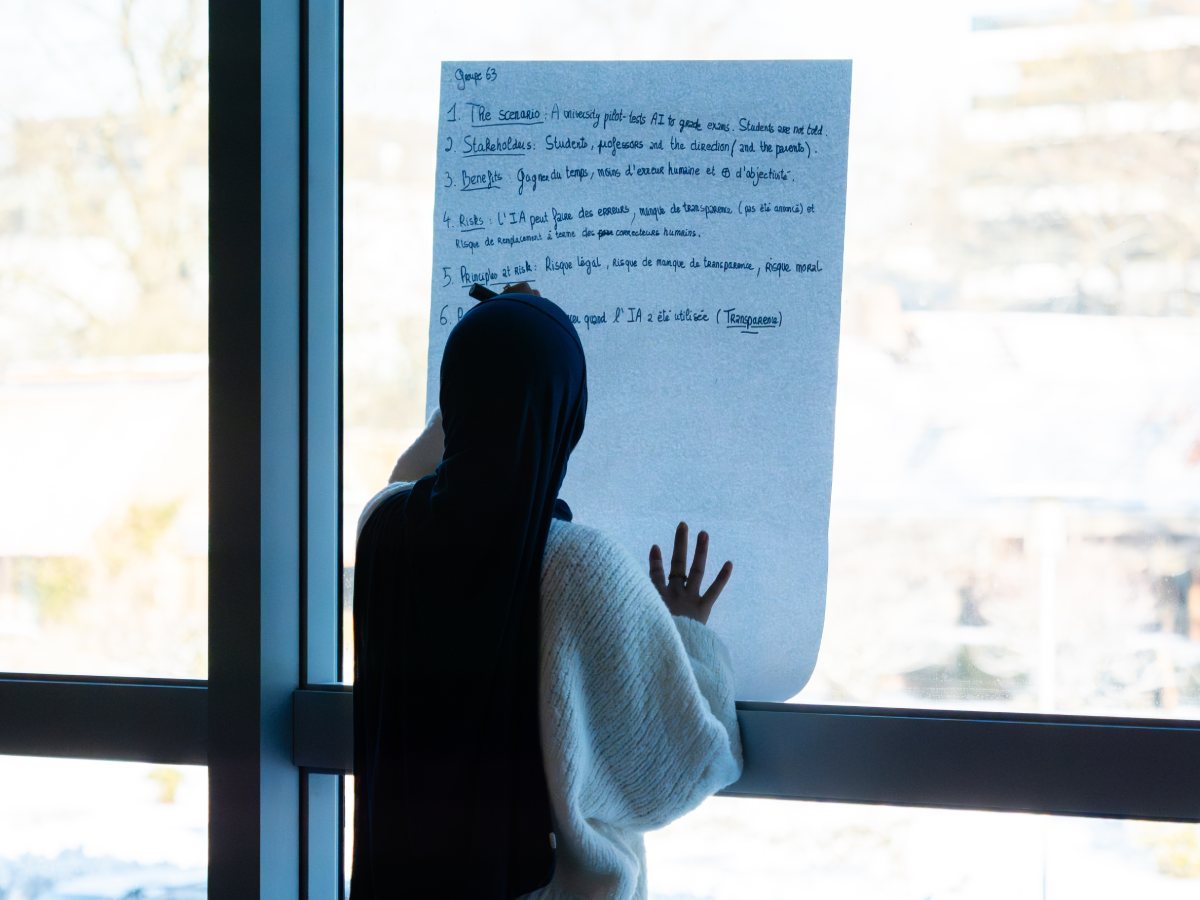

Le second exercice s’articulait autour de cinq études de cas. Celles-ci évoquaient des situations éthiques en milieu académique, où une utilisation inappropriée de l’IA avait été constatée : un test pilote de notation par l’IA conduit par une université, sans en informer les étudiants ; l’usage de l’IA par un élève pour réaliser un projet de groupe, sans prévenir au préalable son équipe ; un professeur créant un cours complet à partir de l’IA, sans en dire un mot à sa classe. Pour chaque cas, les étudiants devaient identifier les parties prenantes impliquées dans le récit, ainsi que les bénéfices et les risques liés à l’utilisation de l’IA. Ils devaient également illustrer les principes éthiques ou réglementaires en lien avec les situations étudiées. A travers cet exercice, les étudiants ont ainsi pu mieux saisir les conséquences d’un mauvais usage de l’IA, que ce soit en matière de qualité d’une production académique ou du non-respect de règles éthiques ou juridiques.

Intégrer la responsabilité au cœur de l’usage de l’IA

L’après-midi, les étudiants ont suivi différentes séquences autour de la notion de responsabilité face à l’IA. Wim Vandekerckhove a évoqué d’autres enjeux éthiques soulevés par l’outil (l’impact environnemental, la sécurité des données, les enjeux géopolitiques) et a souligné les études sur le biais de la machine en fonction du genre.

Puis, pour mettre en lumière les contours de l’IA générative, Victor Planas a décrypté le fonctionnement d’un LLM, démontrant ainsi qu’il s’agit d’un système statistique basé sur des probabilités, et non d’une intelligence consciente. Il a ensuite accompagné les étudiants dans la découverte des différents types de LLM (Claude, ChatGPT, Mistral, …). Par paires, les Pré-Masters ont rédigé différents prompts (informel, créatif, pédagogique) à destination de plusieurs LLM et ont analysé la qualité, les sources, les similitudes ou différences des réponses, et la véracité des réponses.

Pour conclure cette séquence, Michelle Sisto leur a présenté des affaires dans lesquelles des documents, rédigés par des experts, contenaient de fausses informations générées par l’IA : un avocat ayant recours à ChatGPT dans un litige avec une compagnie aérienne ou un rapport pour le gouvernement australien édité par une société de conseil, comportant plusieurs erreurs causées par l’IA. Des exemples marquants, illustrant l’importance de vérifier ses sources. Elle a aussi souligné l’impact de l’IA sur l’évolution du monde du travail actuel et futur. A la suite de ces présentations, les étudiants ont repris leur journal de bord pour compléter la partie consacrée aux effets de l’IA dans leur vie académique, mais aussi en tant que futur professionnel. L’enjeu : leur faire prendre du recul afin qu’ils puissent anticiper la place que cette technologie occupera dans leur développement et leur futur métier.

La dernière partie du bootcamp a été consacrée au cadre d’utilisation de l’IA à l’EDHEC. Les étudiants ont d’abord rédigé en groupe une charte responsable de l’IA en s’appuyant sur leurs connaissances acquises au cours de la journée. Ce manifeste devait incarner une approche éclairée et responsable de l’IA — fondée sur la transparence, le développement de l’esprit critique, la fiabilité des sources et le respect du cadre juridique. Michelle Sisto a ensuite repris la parole pour préciser les principes qui encadrent l’usage de l’IA à l’école, tout en soulevant les questions qui nourrissent la réflexion au sein de l’institution : quel nouveau modèle de dirigeant émergera ? Un professionnel capable de piloter des équipes hybrides, composées d'humains et de systèmes d’IA ? Comment préserver et intégrer le temps long dans nos pratiques, notamment des moments de contemplation et de concentration, face à des outils toujours plus rapides ? Et de quelle manière l’EDHEC peut-elle garantir que les étudiants continuent à se développer intellectuellement tout au long de leurs études en management ? En guise de piste de réponse, Michelle Sisto a conclu en invitant les étudiants : « à ne jamais cesser de cultiver leur créativité et leur esprit critique ».

* Peter Daly, professeur en management et leadership, Emmanuelle Deglaire, professeure en fiscalité et droit, Wim Vandekerckhove, professeur en éthique des affaires, Tuba Bakici, professeure en systèmes d’information, Victor Planas Bielsa, directeur de la filière data science & AI for business et directeur académique des programmes MSc d’EDHEC Online.

** Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task, Nataliya Kosmyna, Eugene Hauptmann, Ye Tong Yuan, Jessica Situ, Xian-Hao Liao, Ashly Vivian Beresnitzky, Iris Braunstein, Pattie Maes, Cornell University, 2025.